![]()

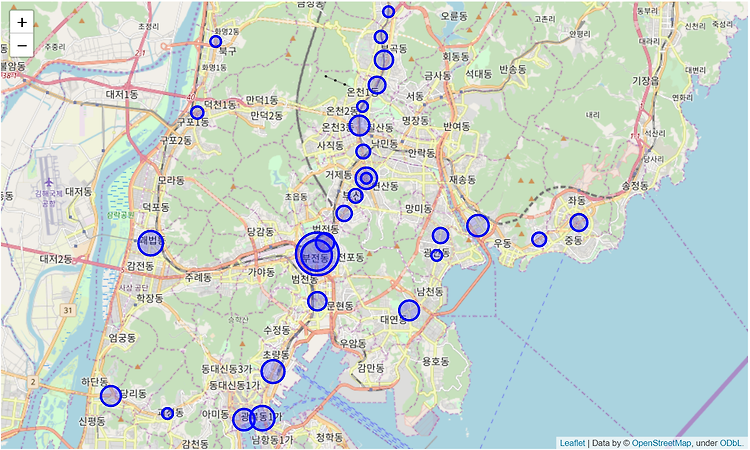

지난번 포스팅에서는 드디어 우리가 원하는 일 평균 이용객수를 역별로 구할 수가 있었답니다. 해당 데이터를 가지고 간단히 상위 30곳을 그래프로 그려보겠습니다. 일단 시각화를 위해서 matplotlib.pyplot을 사용합니다. 그리고 아래 폰트 관련된 부분은 한글이 그래프상에서 깨지는 걸 방지하기 위해서 사용할 한글 폰트 정보를 가져오는 부분이니 거의 그대로 사용하시면 됩니다. 그래서 앞서 만든 데이터 프레임에 타일과 라벨을 간다히 설저하고 bar그래프로 표시해보면 이렇게 됩니다. 아주 이쁘지는 않지만 그럭저럭 볼만 합니다. 이번 포스팅에서는 지도위에 시각화하는 걸 해보겠습니다. 단순하게 바 그래프로 있는 것보다는 실제 지도위에 이용객수를 시각화해서 보여주면 좀 와 닿지 않을까요? python에서는 fo..

![]()

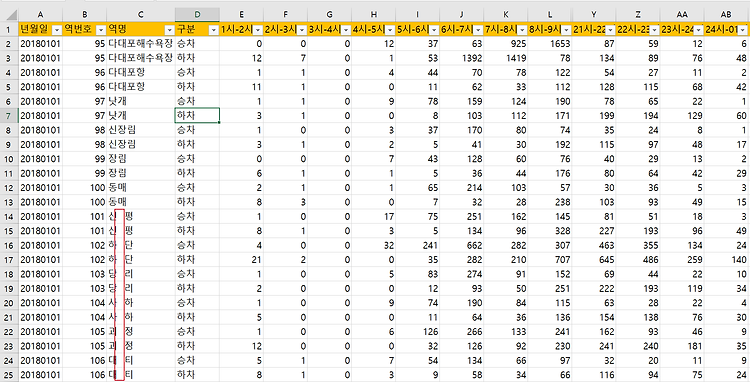

지난 포스팅에서는 데이터 분석을 하기 전에 제공된 데이터셋의 유효성 체크를 하고 약간의 보정을 했었습니다. 이제 본격적으로 원하는 데이터를 만들어보겠습니다. 참 우리가 원하는 데이터는 바로 역별 1일 평균 이용객수이지요. 기본적으로 시간대별로 나누어져 있으니 이걸 합하고, 승/하차 구분이 되어 있으니 이것 역시 합해서 평균을 내주는 방식으로 접근하면 될 것 같습니다. 중요하건 365일에 대한 데이터이니 이걸 일평균으로 다시 한번 해줘야 하고요. 이제 차근차근 진행해 보겠습니다. 1. 우선 시간대별 되어 있는 이용객수를 합(sum)해서 '합계'라는 컬럼을 추가해 보겠습니다. 2. 여기서 우리가 필요한 컬럼만 다시 가져와서 새로운 데이터 프레임에 저장합니다. 사실 우린 합계만 필요하니 아래처럼 필요한 컬럼만..

![]()

이번 포스팅에서는 가져온 Raw 데이터를 분석에 필요한 형태로 정리하고 가공하는 부분을 간단히 소개하겠습니다. 앞선 포스트에서 가져온 데이터가 역별/승하차별/시간대별 로 세분화된 이용객 수가 나온 상태라 우리가 궁금한 일평균 이용객수를 보기 위해서 몇 가지 작업이 필요해 보입니다. python에서 몇가지를 직접 체크를 해봐도 되겠지만, 직관적으로 데이터 이상 여부를 보려고 엑셀에서 csv파일을 열어서 몇 가지 체크를 해봅니다. 물론 데이터 정리 작업 역시 엑셀에서 직접 하고 다시 저장해서 처리해도 무방합니다만 그게 건수가 몇 건 안될 때는 가능하지만 데이터량이 많을 때는 불가능하겠죠. 그래서 전 데이터 변경이나 정리하는 작업은 모두 파이썬에서 직접 처리했습니다. 데이터 변경 내용 살펴보기 1. 역명의 공..

![]()

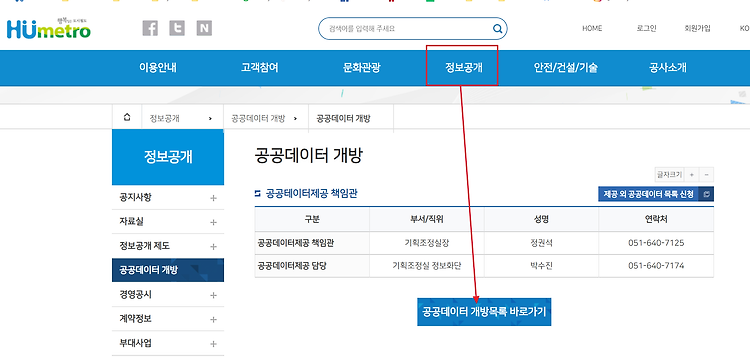

아재도 하는 데이터 분석 첫 번째 포스팅입니다. 여름방학 특강으로 들었던 개인 프로젝트에서 사용했던 데이터 파일에 대한 부분입니다. 요즘은 공공데이터 개방을 많이 하는 추세라 정부를 비롯해 많은 공공기관에서도 보유한 데이터들을 제공하고 있답니다. 그중에서 공공데이터 포털(https://www.data.go.kr/)을 통해서 내가 필요한 데이터셋을 찾아볼 수 있으니 자주 가봐야겠습니다. 프로젝트 시간에 분석하고 싶었던 데이터는 부산 도시철도 역별 이용객수를 확인해보고 싶은 거였습니다. 공공데이터 포털에서 찾을 수도 있지만 일단 부산 지하철을 운용하는 부산교통공사 홈페이지(https://www.humetro.busan.kr/default/main.do)에 가봤습니다. 여기서 정보공개-공공데이터 개방에 갔더니..