![]()

제가 예전에 2019년 말에 스타벅스 매장이 많은 동네가 어디인지 궁금해서 한번 분석을 해본 적이 있습니다. 스타벅스 상권의 특성이 조금은 특이한 면이 있어서, 매년 조금씩 매장 정보를 수집하곤 했었는데요. https://uincity.tistory.com/267 [데이터분석] 스타벅스 매장이 가장 많은 동네는? feat by R & QGIS (300원)저의 요즘 관심사는 부동산 입지 분석입니다. 부동산 입지 분석을 할때 상권 관련된 용어로 '스세권'이란 말이 있습니다. 스타벅스 상권을 부르는 얘기이지요. 그래서 전국의 스타벅스 매장 주uincity.tistory.com 2023년 스타벅스 매장 현황현재 일자(2023.06.15.) 기준으로 매장정보를 수집해보았습니다. 현재 스타벅스 총 1,826개의 매..

![]()

독후감 제목이 매력적이다. 보통 데이터 사이언티스트라고 하면 IT 베이스의 기술력이 있고 컴퓨터과학을 하는 이과생의 주종목이라고 생각하기 쉽다. 저자인 차현나 님의 경우 문과생 출신의 소비자심리를 전공한 분이신데 스타벅스에서 마케팅을 하면서 데이터 분석을 하신 분이시다. 데이터 분석가, 데이터 사이언티스트가 되고 싶은 사람이라면 기술 베이스로 접근하기 쉬운데 기술적인 능력 외에 문과생의 장점이라고 할 수 있는 인문학적 관점의 통찰력이 의외로 중요하다고 강조한다. 통계/ 기술/인문 이 3가지를 조화롭게 가지고 있어야 좋은 데이터 사이언티스가 될수 있을 것이다. 지금 데이터 사이언티스트를 꿈꾸며 공부하고 있을 수많은 예비 데이터 분석가들이 꼭 봤으면 하는 책이다. 대학원에서 통계학을 공부하는 친구들에게도. ..

![]()

들어가며 간만에 돌아왔습니다. 오늘은 한우 사육량 데이터를 가지고 데이터 시각화를 통해서(쉬운 말로 그림과 도표를 잘 그려서) 인사이트(Insight)를 도출해보도록 하겠습니다. (데이터에서 어떤 의미를 알아내어 보자) R에서는 기본적인 plot 외에도 ggplot2라는 막강한 패키지가 데이터 시각화를 주도하고 있습니다. ggplot의 gg의 의미가 grammar of Graphics라는 의미로 그래픽을 문법(텍스트 명령어)으로 나타낸다는 의미입니다. 그래서 각종 명령어와 함수를 익혀놓으면 강력한 시각화가 가능합니다만, 역시 익숙해지기 전까지는 어려운 영역이기도 합니다. 제가 전에 포스팅했던 대부분의 데이터 분석 포스팅에도 미약하지만 ggplot을 대부분 사용했었습니다. 그만큼 필수적이기도 합니다. 데이..

![]()

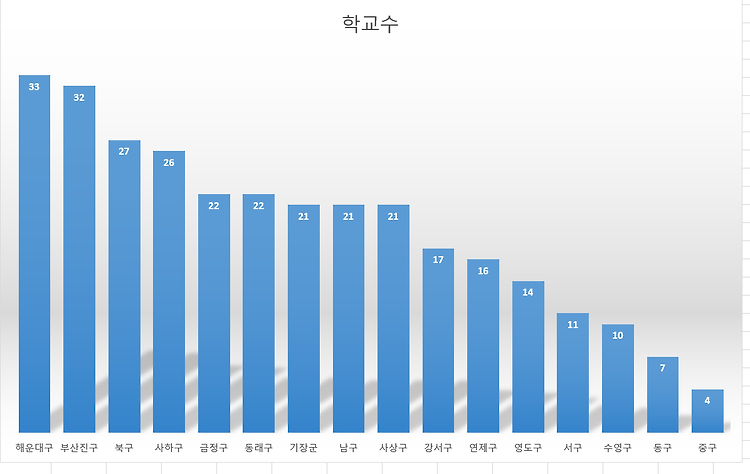

들어가며 오늘은 부산지역 데이터를 가지고 분석하는 4번째 분석 포스팅입니다. 최근에 부동산 입지 관련 공부를 하면서 학군에 꽂혀서, 이것저것 보다가 심정섭 님의 '심정섭의 대한민국 학군 지도' 란 책을 보게 되었습니다. 학군에 관심이 많고 자녀 교육에 관심이 많으신 분이시라면 필독해도 좋을 책입니다. 거기다가 부동산에 관심이 많으신 분들도 역시 읽으시면 좋지 않을까 생각합니다. 이번 분석의 아이디어는 책 초반부에 있는 '학교 재학생 수로 해당 지역 학군의 미래를 보는 법' 과 '신도시 신생 학군의 성장 가능성을 알아보는 법' 이란 두 가지 섹션에서 가져왔습니다. 저출산 시대에 학생 수 역시 감소하고 있습니다. 부산 시내에서도 어떤 학교들은 재학생 수가 줄어서 폐교하거나 통폐합할 학교들도 있고, 또..

![]()

저의 요즘 관심사는 부동산 입지 분석입니다. 부동산 입지 분석을 할때 상권 관련된 용어로 '스세권'이란 말이 있습니다. 스타벅스 상권을 부르는 얘기이지요. 그래서 전국의 스타벅스 매장 주소를 기반으로 어느 지역에 얼마나 있는지? 특히 제가 살고 있는 부산에는 어떻게 분포하는지? 스타벅스 매장수와 어떤 데이터가 상관관계가 높을지? 가 궁금해졌습니다. 구글링 해보니 공공데이터의 상권정보를 가지고 분석한 경우와 스타벅스홈페이지의 매장정보를 가져와서 분석해보신분들이 이미 많이 계시더라구요(나중에 함께 읽으면 좋을글 에서 더 보시면 됩니다.) 하지만 제가 통계와 데이터 분석을 공부하는 사람으로써 뭔가 약간 부족해보였습니다. 그래서 제가 한번 분석 해보았습니다. (R과 QGIS를 사용했습니다.) 1. 스타벅스 매장..

![]()

지난 주말에 ADsP 시험을 보고 왔답니다. 방학 동안 그래도 뭔가 해야 하지 않을까 해서 8월 초에 덜컥 접수했는데 시험이 8월의 마지막 날, 방학의 마지막 날인 8/31일이었답니다. 저는 부산지역이라 시험장소는 벡스코 제1전시장의 2층, 3층 회의실에서 시험을 봤답니다. (참고로 시험 시 계산기 사용불가, 컴퓨터용 사인펜이 필요합니다.) ADsP의 경우 ADP와 달리 경력이나 자격제한이 따로 없어서 대학생 신분일 때도 혹은 비전공자인 경우도 시험을 볼 수가 있습니다. 시험 과목 역시 ADP보다는 2과목 적은 3과목에 실기시험이 없답니다. 난이도나 합격률측면에서는 ADP보다는 확실이 쉬운 시험이라고 볼수 있습니다. 그럼에도 불구하고 시험은 시험이라.... 간단히 제가 했던 공부 내용을 공유할까 합니다...

![]()

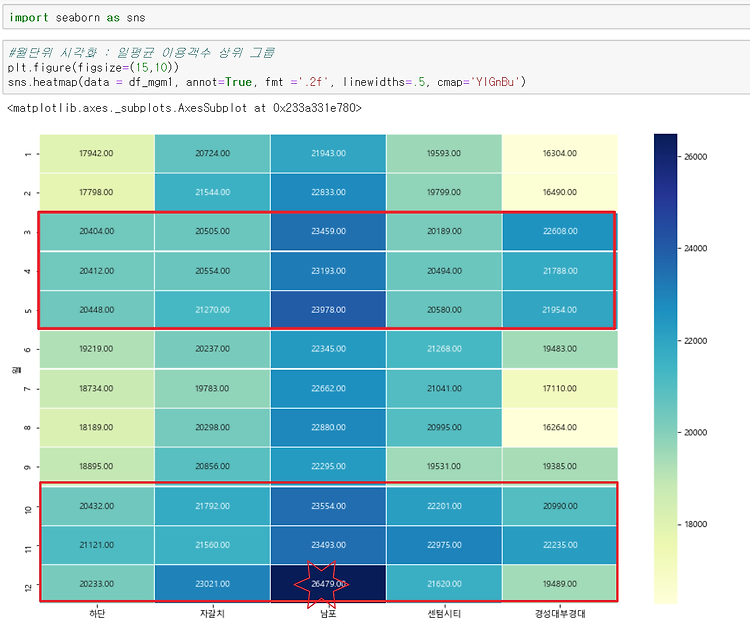

이번 포스팅에서는 지난번 도시철도 일자별 승하차 이용객수 데이터를 가지고 부산의 주요 관광지가 있는 곳의 주요 역들의 이용형태를 한번 파악해보겠습니다. 기본적으로 부산하면 해운대나 광안리가 떠오르시는 분이 많은데, 이런곳들은 역시 해수욕장 근처라 아무래도 여름휴가철에 도시철도역 이용객도 좀 많지 않을까요? 그리고 1년에 한 번 하는 광안리 불꽃축제 때는 아무래도 이용객수가 급증할 것 같은 건 어느 정도 예상해볼 수 있죠. 지하철 이용객수만으로 관광지 혹은 특별한 이벤트(축제)와 관련이 있는지 한번 살펴보는 게 이번 포스팅의 목적입니다. 분석대상 역은 아래와 같습니다. 일단 부산교통공사의 문화관광 카테고리의 시티투어-호선별 관광정보를 참고했습니다. 아직 저도 못가본 곳이 많네요. 참고로 도시철도로 떠나는 ..

![]()

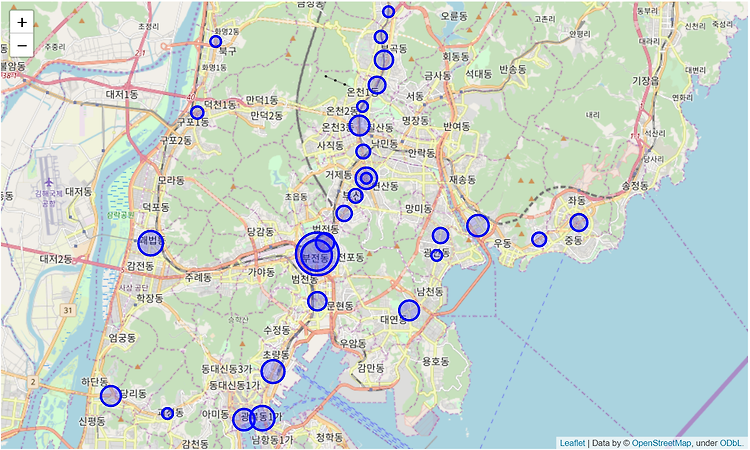

지난번 포스팅에서는 드디어 우리가 원하는 일 평균 이용객수를 역별로 구할 수가 있었답니다. 해당 데이터를 가지고 간단히 상위 30곳을 그래프로 그려보겠습니다. 일단 시각화를 위해서 matplotlib.pyplot을 사용합니다. 그리고 아래 폰트 관련된 부분은 한글이 그래프상에서 깨지는 걸 방지하기 위해서 사용할 한글 폰트 정보를 가져오는 부분이니 거의 그대로 사용하시면 됩니다. 그래서 앞서 만든 데이터 프레임에 타일과 라벨을 간다히 설저하고 bar그래프로 표시해보면 이렇게 됩니다. 아주 이쁘지는 않지만 그럭저럭 볼만 합니다. 이번 포스팅에서는 지도위에 시각화하는 걸 해보겠습니다. 단순하게 바 그래프로 있는 것보다는 실제 지도위에 이용객수를 시각화해서 보여주면 좀 와 닿지 않을까요? python에서는 fo..

![]()

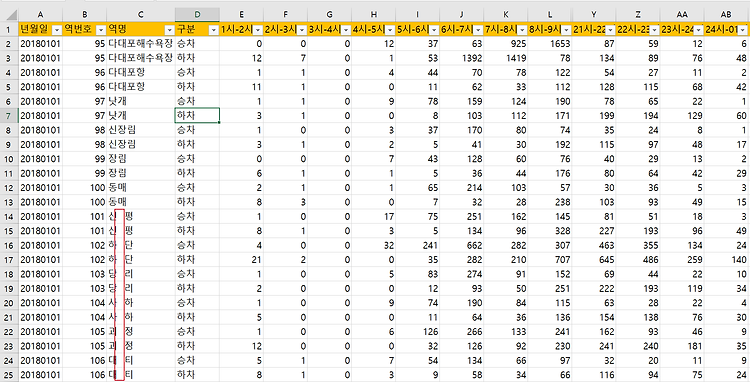

지난 포스팅에서는 데이터 분석을 하기 전에 제공된 데이터셋의 유효성 체크를 하고 약간의 보정을 했었습니다. 이제 본격적으로 원하는 데이터를 만들어보겠습니다. 참 우리가 원하는 데이터는 바로 역별 1일 평균 이용객수이지요. 기본적으로 시간대별로 나누어져 있으니 이걸 합하고, 승/하차 구분이 되어 있으니 이것 역시 합해서 평균을 내주는 방식으로 접근하면 될 것 같습니다. 중요하건 365일에 대한 데이터이니 이걸 일평균으로 다시 한번 해줘야 하고요. 이제 차근차근 진행해 보겠습니다. 1. 우선 시간대별 되어 있는 이용객수를 합(sum)해서 '합계'라는 컬럼을 추가해 보겠습니다. 2. 여기서 우리가 필요한 컬럼만 다시 가져와서 새로운 데이터 프레임에 저장합니다. 사실 우린 합계만 필요하니 아래처럼 필요한 컬럼만..

![]()

이번 포스팅에서는 가져온 Raw 데이터를 분석에 필요한 형태로 정리하고 가공하는 부분을 간단히 소개하겠습니다. 앞선 포스트에서 가져온 데이터가 역별/승하차별/시간대별 로 세분화된 이용객 수가 나온 상태라 우리가 궁금한 일평균 이용객수를 보기 위해서 몇 가지 작업이 필요해 보입니다. python에서 몇가지를 직접 체크를 해봐도 되겠지만, 직관적으로 데이터 이상 여부를 보려고 엑셀에서 csv파일을 열어서 몇 가지 체크를 해봅니다. 물론 데이터 정리 작업 역시 엑셀에서 직접 하고 다시 저장해서 처리해도 무방합니다만 그게 건수가 몇 건 안될 때는 가능하지만 데이터량이 많을 때는 불가능하겠죠. 그래서 전 데이터 변경이나 정리하는 작업은 모두 파이썬에서 직접 처리했습니다. 데이터 변경 내용 살펴보기 1. 역명의 공..